程序员要被镌汰了,这可能不是危言耸听。

这个职业原本险些是“金饭碗”一样的存在,手艺门槛高、磨练缔造力,收入也高。但ChatGPT的问世,改变了这种固有态势。

最近这两天,GPT还升级到了第四代——GPT-4。

要知道,上一代ChatGPT已经具有*的语义明晰能力。虽然这种能力仅限于文字处置,但也已经有公司在使用ChatGPT相关手艺,替换掉一些低级程序员的事情了。

而GPT-4不光文字明晰能力更高,尚有*的图片明晰能力,就连一些互联网梗图都能读懂。

这还不是GPT-4的所有实力。在GPT开发者OpenAI公布的演示视频中,GPT-4能凭证一张异常潦草的demo图,在10秒之内天生一个网站页面。

10秒,是人类无论若何都不能能到达的速率,但AI可以。而且才100多天,它就跃进到了这个水平。

下一代GPT又会有何等壮大的能力呢?这既让人期待和兴奋,又感受有点后背发凉。

1.GPT-4,无所不能?

上一代GPT并不是*代,版本号着实是“3.5”。但由于其文字明晰能力对照强,尤其对话交流显示异常“顺滑”,以是才被称为“ChatGPT”。

比起许多犹如“人工智障”的AI助手,ChatGPT给出的回覆更像人类,但也不是毫无破绽。有用户问过ChatGPT:“林黛玉三打白骨精是怎么回事?”

ChatGPT还真给胡诌出了一段故事,看起来有点像从网友二创作品中提炼出来的剧情。

林黛玉三打白骨精是怎么回事?/知乎答主@连诗璐

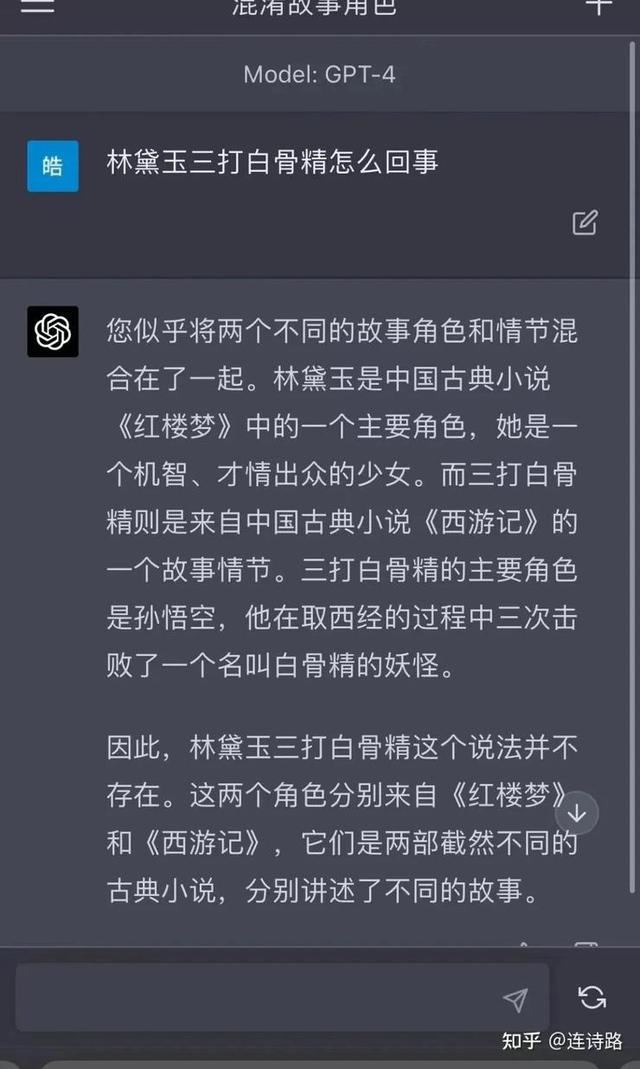

但拿同样的问题去问GPT-4,它会提醒用户不要夹杂《红楼梦》和《西游记》的剧情。

ChatGPT有点像喝醉了在说胡话,而GPT-4保持了苏醒。/知乎答主@连诗璐

若是你以为GPT-4的文字明晰能力只停留在“语句”的水平,那你就错了。GPT-4还可以明晰“代码语言”。

在GPT-4的产物视频中,OpenAI总裁直接把一段1万字的代码发给GPT-4,让它修bug。效果GPT-4只用了几秒钟就找到了bug,而且分点给出领会决设施。换做是程序员去找,绝不能能有这个效率。

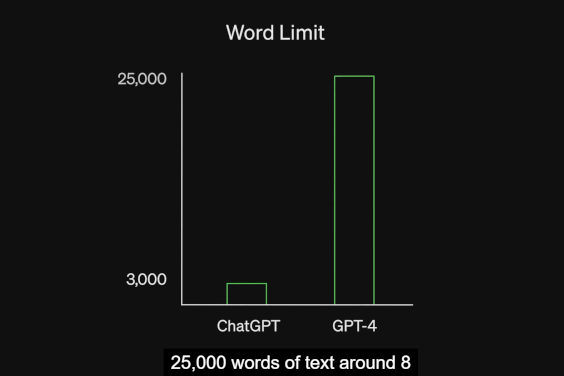

这次升级和更新之后,OpenAI还将GPT-4处置文字内容的上限拓展到了2.5万个字符,这是ChatGPT上限的8倍。这意味着,GPT-4可以处置更大的信息量。

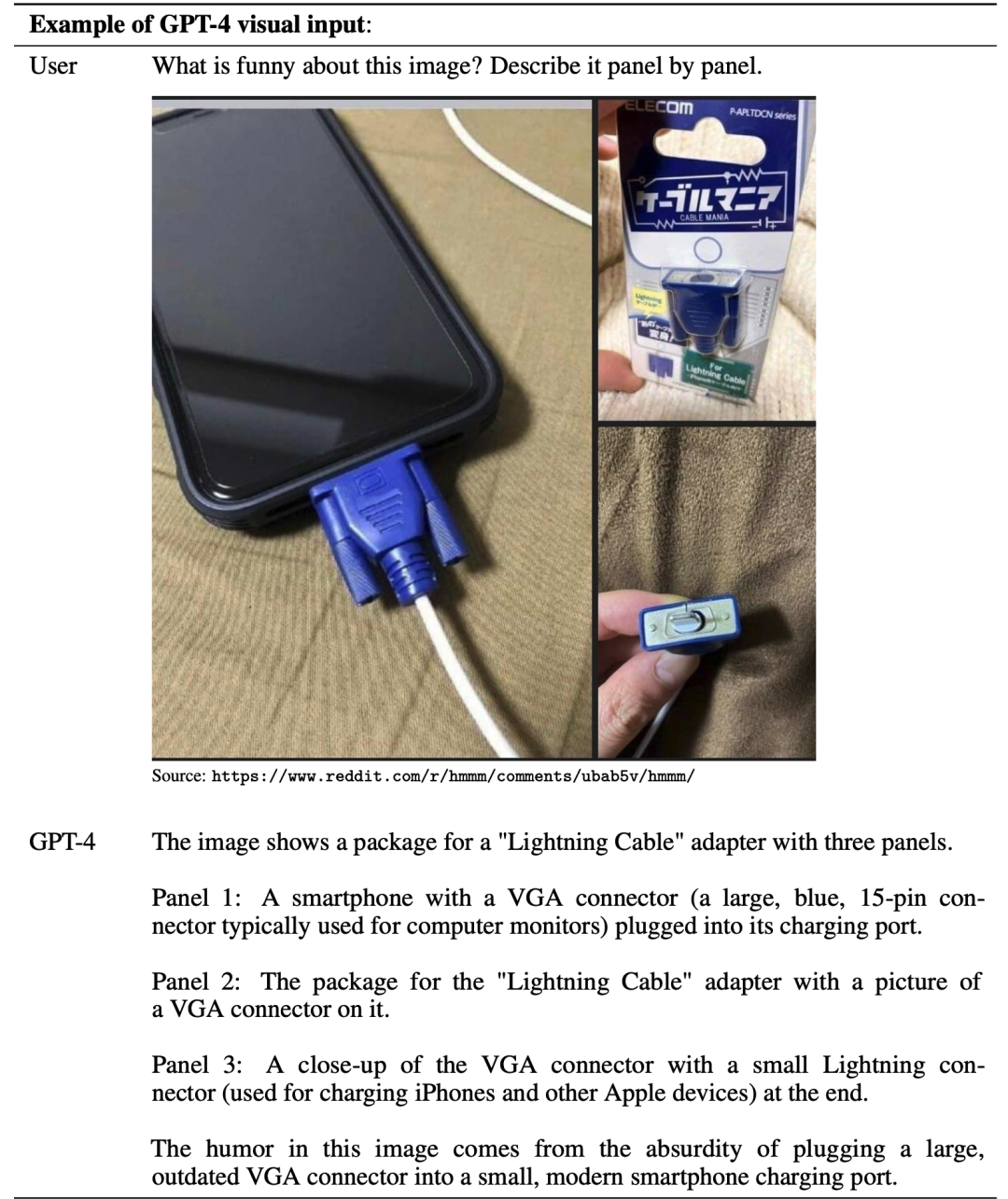

GPT-4更为突出的能力体现在图片明晰方面。

在OpenAI公布的产物视频中,开发者给GPT-4看了一张“用VGA电脑接口给iPhone充电”的图片,并问GPT-4“笑点在那里”,GPT-4在条分缕析之后得出了却论:

“这张图搞笑的地方在于,它将一个很大而且过时的VGA接口插在一个很小而且现代的智能手机充电口上,这很谬妄。”

GPT-4是懂诙谐的。

更主要的是,它还能把对图片和文字的明晰连系起来,同步举行。

好比,给GPT-4一些统计图表举行剖析,GPT-4能高效地得出结论、发现问题,并迅速反馈给使用者。甚至直接把整篇论文截图上传给GPT-4,它都能在几秒之内归纳综合出论文的焦点内容来。

未来,大公司的财报、销售营业数据等内容,即便图表内容再庞大、内容维度再多、数据量再大,只要不跨越2.5万个字符的限制,GPT-4都能剖析得清晰。

云云看来,似乎GPT-4险些可以秒杀相当一部门人类了,程序员、金融剖析师、数据剖析师、音乐创作人(GPT-4可以自己写歌)都要下岗。

至少,低级程序员会被镌汰。/微博截图

2.GPT性能跃进,留给人类的时机不多了?

问题来了,GPT-4连代码里的bug都能自己修,就不怕它自我进化,最后发生自主意识取代人类吗?

谜底是:现在不会,由于GPT-4也不是*无缺的。

虽然它是多模态模子,现在已经可以处置文字和图片两种“模态”,这比ChatGPT只能处置文字的“单模态模子”提高了许多,但也仅限于此。

至少,现在它还剖析不了声音和视频。后续的版本一定会笼罩这些“模态”,以增强AI的明晰能力。

事实上,对声音的明晰会加倍庞大,好比一句话中的语气、停留都包罗着信息。另外尚有非语言类声音,好比风声、撞击声,以及声音距离、方位的鉴别,都是需要突破的点。而视频图像会更庞大,对这些手艺的攻坚,势需要耗时更久。

固然,这也只是时间问题。

现在来看,它尚有一个显著的问题就是,容易发生“AI幻觉”,天生错误谜底,并泛起逻辑错误。

所谓“AI幻觉”,是指模子过于自信,天生的内容与提供的源内容无关或不忠实,有时会泛起听起来合理,但不准确或谬妄的谜底,好比上文中提及的“林黛玉三打白骨精”问答。

中国信通院云盘算与大数据研究所所长何宝宏曾在接受采访时指出,“ChatGPT的幻觉来自两个方面,一是训练数据自己,二是训练方式。AI是通过海量数据训练出来的,因此这一瑕玷也与大数据的问题一样:数据很正确但错得离谱”。

若是过于依赖AI,那么由这种幻觉导致的禁绝确性,显然会影响一些营业的正常举行。这就意味着,人工必须对其反馈的剖析举行复核,这是AI取代不了的职责和需要性。

幸亏GPT迭代至今,其能力都仅限于被动响应。也就是说,岂论是ChatGPT照样GPT-4,它们的信息读取能力都只是对人类提问的反馈,而不会自动去评判或者剖析。

这一点“被动”的属性很要害,一方面能让AI处于隶属职位,只会被动解决人类提出的问题。这一点,应当成为AI行业不能逾越的红线,否则就会晤临许多贫苦,好比AI的自我演进,AI的权益和福利问题,AI越过防火墙举行监听,甚至衍生出黑客行为……

另一方面,这也对人类提出了更高的要求,好比提问能力。

很显然,GPT-4是凭证指令举行剖析的,那就是说,只有在指令或提问明确、清晰的情形下,GPT-4才气给出针对性的谜底。否则,若是问得很浅,那获得的反馈也只会是和百科一样的外面回覆。

一个会让人警铃大作的新闻是,著名金融服务公司摩根士丹利已经在现实营业中使用了GPT。

摩根士丹利的事情职员所面临的伟大内容库,涵盖了投资计谋、市场研究和谈论以及剖析师看法等长达数十万页的内容。这些信息大多以PDF名堂漫衍在内部网站上,需要浏览大量信息才气找到特定问题的谜底,检索起来费时艰苦。

而GPT高效的信息处置能力,让这部门事情量获得了有用疏解。

但这也意味着,这部门信息处置类的低级岗位将要被镌汰,留下来的人一定要具备更强的洞察力,而且能提出好的问题来指导GPT。

以是,就现在来看,人类还不用为被AI取代而郁闷,但*不能躺平大意,而是要不停增强自己的水平,让AI取代不了自己。